在全球人工智能浪潮中,中國正積極推動構建安全、可靠、可控的“可信人工智能”體系。這一“中國方案”不僅關乎技術發展,更強調以人為本、科技向善的治理理念。可信AI系統并非單一技術突破的產物,而是由一系列支撐技術構成的復雜生態系統,這些技術共同為人工智能應用的軟件開發奠定了堅實基礎。

一、構建可信AI系統所需的關鍵支撐技術

- 數據安全與隱私計算技術:這是可信AI的基石。包括:

- 聯邦學習:允許多方在數據不離開本地的情況下協同訓練模型,實現“數據可用不可見”。

- 差分隱私:通過在數據或模型參數中添加精心設計的噪聲,保護個體信息不被泄露。

- 同態加密與安全多方計算:允許對加密數據進行直接計算,確保數據處理全流程的機密性。

- 數據脫敏與匿名化:從源頭減少敏感信息暴露風險。

- 算法可解釋性與魯棒性技術:

- 可解釋AI(XAI):通過可視化、特征重要性分析、自然語言解釋等方法,使“黑箱”模型的決策過程對開發者、監管者和用戶透明。

- 對抗性魯棒性:增強模型抵御惡意輸入(對抗樣本)的能力,確保其在復雜、對抗環境下的穩定性和可靠性。

- 公平性檢測與消偏算法:識別并修正訓練數據或算法中可能存在的偏見,確保決策公正,不歧視任何群體。

- 系統可靠與可控技術:

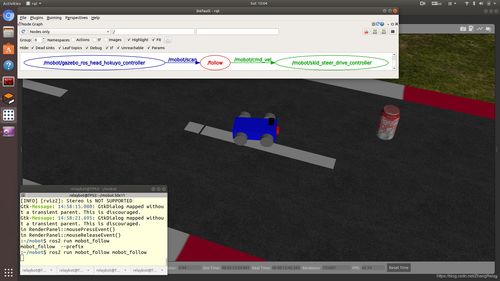

- 持續監測與驗證:在模型部署后,持續監控其性能、行為和數據分布變化,及時發現并糾正模型漂移或異常。

- 失效安全與回滾機制:當AI系統出現不可預測的故障或有害輸出時,能自動或手動觸發安全機制,切換到安全狀態或可信任的舊版本。

- 形式化驗證:運用數學方法嚴格證明系統在特定條件下的行為符合預設的安全規范。

- 治理與合規支撐技術:

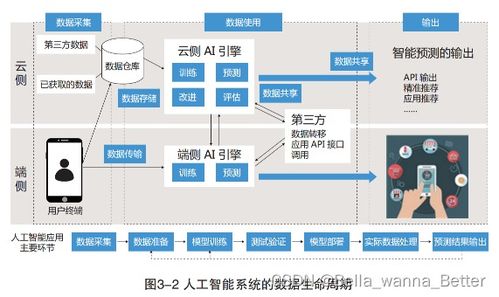

- AI審計與溯源技術:記錄模型開發、訓練、部署的全生命周期數據,實現全過程可追溯、可審計。

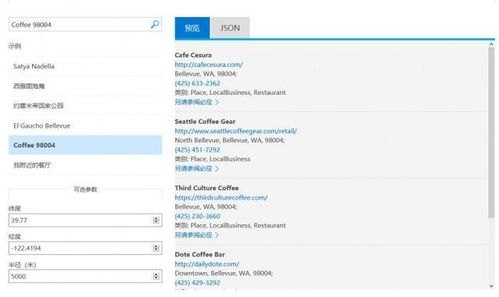

- 合規性自動檢查工具:幫助開發者和企業自動檢測AI系統是否符合相關法律法規和標準(如中國的《生成式人工智能服務管理暫行辦法》)。

二、面向可信AI的應用軟件開發實踐

在可信AI的“中國方案”指引下,應用軟件的開發流程需深度融合上述支撐技術,并體現以下特點:

- “可信內嵌”的開發范式:可信屬性不再是事后附加,而是在軟件需求分析、架構設計、編碼、測試、部署、運維的全生命周期中優先考慮和內置。開發團隊需要建立“安全左移”和“可信設計”的文化。

- 模塊化與標準化的可信組件庫:開發基于中國標準(如《人工智能 可信賴 第1部分:總體框架》等系列國標)的可信AI軟件工具包、開發框架和中間件。例如,集成隱私計算算子、可解釋性分析模塊、公平性評估插件的SDK,降低開發者的技術門檻。

- 人機協同與交互設計:軟件設計需強調人的監督與控制權。例如,在關鍵決策環節設置“人在回路”機制,提供清晰的可解釋界面,讓用戶理解AI的建議并保留最終決定權。

- 場景驅動的可信需求細化:不同應用場景(如金融風控、醫療診斷、自動駕駛、內容生成)對可信維度的要求側重點不同。開發過程需首先明確具體場景下的核心可信指標(如醫療AI的可解釋性要求極高,金融AI則強調公平性與審計溯源),并據此進行技術選型和設計。

- 持續運維與動態評估:可信AI軟件開發并非以部署上線為終點。需建立持續的模型性能與行為監控體系,利用支撐技術動態評估其可信度,并建立快速迭代和更新的流程。

###

構建可信AI的“中國方案”,是一個融合技術創新、標準制定、倫理規范和產業實踐的系統工程。其核心支撐技術為打造可靠、透明、公平、安全的人工智能提供了工具集。而將這些技術有效、系統地融入人工智能應用軟件的開發全流程,則是將“可信”理念落地的關鍵。隨著技術的不斷成熟和生態的完善,以可信為基石的中國AI應用,將在賦能千行百業的更好地守護安全、增進福祉,引領全球人工智能治理的新方向。